هوش مصنوعی در خدمت ماشین ترور رژیم صهیونیستی/ هوش مصنوعی چگونه دانشمندان هسته ای ایران را ترور میکند؟

به گزارش خبرنگار امنیت دفاعی خبرگزاری دانشجو ؛ ماهیت جنگ در حال یک تحول بنیادین است که توسط هوش مصنوعی (AI) هدایت میشود. این دگرگونی فراتر از بهبود تدریجی تسلیحات، به بازآرایی کامل فرآیندهای اعمال خشونت مرگبار رسیده است. در قلب این انقلاب، «زنجیره کشتار» قرار دارد - دنبالهای از اقدامات شامل یافتن، ردیابی، هدفگیری و در نهایت درگیری با دشمن. این فرآیند که در گذشته انسانمحور و زمانبر بود، اکنون توسط الگوریتمهایی فشرده و تسریع شده است که قادرند اطلاعات را با سرعت و مقیاسی فراتر از توانایی شناختی انسان پردازش کنند.

رژیم صهیونیستی، به عنوان یکی از پیشگامان این عرصه، روایتی فریبکارانه از این فناوری ارائه میدهد و آن را ابزاری برای جنگی پاکتر و جراحیگونه با حداقل آسیب جانبی معرفی میکند. با این حال، جامعترین کاربرد واقعی این فناوری تا به امروز - یعنی استقرار مجموعهای از سیستمهای هدفگیری هوشمند در نوار غزه - هدفی کاملاً متفاوت و عمیقاً نگرانکننده را آشکار میسازد. در این زمینه، هوش مصنوعی نه برای دقت، بلکه برای تولید انبوه اهداف و غلبه بر «تنگنای انسانی» در یک جنگ با شدت و کشتار بیسابقه به کار گرفته شده است. این کاربرد، هوش مصنوعی را از یک ابزار نظری برای جنگ جراحی به موتور محرک چیزی تبدیل کرده است که افسران اطلاعاتی سابق آن را «کارخانه ترور جمعی» توصیف کردهاند.

بخش ۱: معماری ماشین ترور صهیونیستی

ارتش رژیم صهیونیستی برای اجرای دکترین خود متکی به یک سهگانه الگوریتمی است که هر یک وظیفهای مشخص اما مکمل در خط تولید مرگ دارند. این سیستمها با هم، یک زنجیره کاملاً خودکار برای تولید و اجرای حملات مرگبار را تشکیل میدهند که از شناسایی سازههای قابل هدفگیری تا ایجاد لیستهای کشتار انسانی و در نهایت، هدایت حملات به افراد در خانههایشان را شامل میشود.

«هابسورا» (Habsora): هوش مصنوعی تخصصی ترور از طریق حمله به سازه ها

«هابسورا» یک سیستم پشتیبانی تصمیمگیری مبتنی بر هوش مصنوعی است که عمدتاً برای شناسایی ساختمانها و سازهها به عنوان اهداف نظامی بالقوه طراحی شده است. این سیستم توسط واحد اطلاعاتی نخبه ۸۲۰۰ ارتش اسرائیل برای حل مشکلی که رهبران نظامی در درگیریهای قبلی با آن مواجه بودند - یعنی تمام شدن اهداف - توسعه یافت. «هابسورا» با پردازش حجم عظیمی از دادههای اطلاعاتی تلفیقی، از جمله فیلمهای پهپادی، شنود ارتباطات و اطلاعات نظارتی، میتواند اهداف را با سرعتی سرسامآور توصیه کند. به گفته یکی از روسای سابق ستاد ارتش اسرائیل، این سیستم نرخ تولید هدف را از حدود ۵۰ هدف در سال به ۱۰۰ هدف در روز افزایش داده است.

مقامات صهیونیست ادعا میکنند که یک تحلیلگر انسانی باید هر توصیه سیستم را بررسی و تأیید کند، اما منابعی که با روزنامهنگاران صحبت کردهاند، تأثیر اصلی این سیستم را ایجاد یک «کارخانه ترور جمعی» توصیف میکنند که در آن حجم عظیم اهداف تولید شده، هرگونه ظرفیتی برای بررسی معنادار انسانی را از بین میبرد و به کارزاری از تخریب گسترده دامن میزند.

«لوندر» (Lavender)/ هوش مصنوعی آماده سازی لیست اشخاص در اولویت ترور

درحالیکه «هابسورا» سازهها را هدف قرار میدهد، سیستم «لوندر» انسانها را هدف میگیرد. «لوندر» یک پایگاه داده مبتنی بر هوش مصنوعی است که افراد را به عنوان نیروهای مشکوک در شاخههای نظامی حماس و جهاد اسلامی فلسطین علامتگذاری کرده و عملاً یک لیست کشتار ایجاد میکند. این سیستم طیف وسیعی از دادههای رفتاری و اجتماعی را برای ارزیابیهای خود تحلیل میکند. این «ویژگیها» میتواند شامل عضویت در یک گروه واتساپ با یک مبارز شناختهشده، تغییر مکرر آدرس، داشتن مخاطبین تلفنی خاص یا ارتباط با افراد مشخص در رسانههای اجتماعی باشد.

بر اساس این ویژگیها، «لوندر» به هر فردی که تحلیل میکند، یک امتیاز از ۱ تا ۱۰۰ اختصاص میدهد که نشاندهنده احتمال محاسبهشده توسط ماشین برای مبارز بودن آن شخص است. افرادی که از یک آستانه مشخص عبور کنند، به طور خودکار به لیست کشتار اضافه میشوند. در اوج خود، سیستم «لوندر» تا ۳۷,۰۰۰ فلسطینی را برای ترور احتمالی علامتگذاری کرده بود. این سیستم امکان گسترش چشمگیر سیاست هدفگیری را فراهم آورد تا هزاران مبارز ردهپایین را نیز شامل شود که در درگیریهای گذشته، اهداف باارزشی محسوب نمیشدند و به مرور سراغ آن ها خواهند رفت.

?Where's Daddy، سیستم ردیابی خانگی اشخاص لیست ترور، الگوی اجرایی در ایران

سومین جزء این سهگانه الگوریتمی، سیستمی است که با نام «بابا کجاست؟» شناخته میشود. وظیفه آن ردیابی لحظهای افرادی است که در لیست کشتار «لوندر» قرار گرفتهاند و هشدار دادن به اپراتورها هنگامی که یک هدف وارد خانه خانوادگی خود میشود. به گفته افسران اطلاعاتی، این سیستم یک ابزار تصادفی نبود، بلکه عمداً برای تسهیل یک سیاست عامدانه بمباران اهداف در خانههایشان طراحی شده بود. این سیستم عملاً فرآیند مکانیابی اهداف را در آسیبپذیرترین حالتشان، یعنی در کنار خانوادههایشان، خودکار کرده و زمینه را برای یک حمله هوایی فراهم میآورد. مواردی مانند ترور شهیدان تهرانچی، باقری، ذوالفقاری و خانواده صدیقی صابر از نمونه ترور های الگوی پدر کجاست که ترور خانوادگی در قالب حمله به خانه است محسوب می شود. یکی از اهداف ترور خانگی، افزایش ضربه پذیری سوژه ترور است.

بخش ۲: دکترین کاربرد: سرعت، مقیاس و مجوز کشتار

وجود این سیستمهای هوش مصنوعی تنها بخشی از داستان است. تأثیر ویرانگر آنها ناشی از دکترین عملیاتی است که بر استفاده از آنها حاکم است - دکترینای که با اولویت دادن به سرعت و مقیاس بر دقت، و یک مجوز فوقالعاده افراطی در مورد تلفات غیرنظامیان مشخص میشود.

مجوزهای از پیش صادر شده برای کشتار غیرنظامیان

شاید تکاندهندهترین جنبه این دکترین عملیاتی، تعیین محدودیتهای از پیش مجاز برای تعداد غیرنظامیانی بود که میتوانستند به عنوان «خسارت جانبی» در یک حمله کشته شوند. به گفته منابع، برای ترور یک مبارز ردهپایین که توسط «لوندر» مشخص شده بود، ارتش مجوز کشتار تا ۱۵ یا ۲۰ غیرنظامی را صادر کرده بود. برای فرماندهان ارشد، این تعداد از پیش مجاز حتی بالاتر بود و منابع بیان میکنند که برای برخی اهداف، ارتش مجوز کشتار «بیش از ۱۰۰ غیرنظامی» را صادر کرده بود. این عمل نشاندهنده یک انحراف رادیکال از اصول حقوق بینالملل است و عملاً الزامات ارزیابی تناسب در هر مورد را با یک مجوز طبقهبندیشده و از پیش تأیید شده برای کشتار غیرنظامیان در مقیاس وسیع جایگزین میکند.

بخش ۳: پرونده ترور دانشمندان ایرانی: یک جنگ الگوریتمی

دکترین و فناوری که در غزه برای کشتار جمعی به کار گرفته شده، یک مدل عملیاتی خطرناک را به نمایش میگذارد که به طور مستقیم برای ترورهای هدفمند علیه دشمنان رژیم صهیونیستی، به ویژه جمهوری اسلامی ایران، قابل استفاده است. پیچیدگی، دقت و ماهیت کنترل از راه دور ترور دانشمندان هستهای و مقامات دفاعی ایران، همگی نشانههایی از یک جنگ الگوریتمی را در خود دارند.

ترور شهید محسن فخریزاده، دانشمند برجسته هستهای و دفاعی ایران، نمونه بارز این پارادایم جدید است. گزارشها حاکی از آن است که این عملیات با استفاده از یک مسلسل کنترلشونده از راه دور و مجهز به هوش مصنوعی انجام شده است. میتوان این فرآیند را با استفاده از معماری ماشین ترور صهیونیستی بازسازی کرد:

1. جمعآوری و تلفیق دادهها (معادل «هابسورا»): ماهها یا حتی سالها، دادههای مربوط به زندگی و رفتوآمد شهید فخریزاده از منابع مختلف - جاسوسان انسانی (HUMINT)، شنود ارتباطات (SIGINT)، تصاویر ماهوارهای (GEOINT) و دادههای منبعباز (OSINT) - جمعآوری و به یک سیستم هوش مصنوعی خورانده شده است. این سیستم الگوهای رفتاری، مسیرهای معمول، آسیبپذیریهای امنیتی و بهترین فرصت برای حمله را مدلسازی کرده است.

2. شناسایی و تأیید هدف (معادل «لوندر»): در روز عملیات، الگوریتمهای بینایی کامپیوتری (Computer Vision) که بر روی تصاویر شهید فخریزاده آموزش دیدهاند، وظیفه شناسایی چهره او را در لحظه بر عهده داشتهاند. این سیستم با دقت بالا چهره او را از دیگر سرنشینان خودرو تشخیص داده و هویت هدف را برای سیستم تسلیحاتی تأیید کرده است. این فرآیند جایگزین شناسایی انسانی شده و خطای انسانی را به حداقل رسانده است.

3. اجرای حمله خودکار (معادل «بابا کجاست؟»): پس از تأیید هویت، سیستم تسلیحاتی خودکار (Lethal Autonomous Weapon System - LAWS) بدون دخالت مستقیم انسان در لحظات پایانی، تصمیم به شلیک گرفته است. الگوریتم، بهترین زاویه و زمان را برای شلیک محاسبه کرده تا اطمینان حاصل شود که فقط هدف اصلی مورد اصابت قرار میگیرد و عملیات با موفقیت انجام میشود.

این مدل عملیاتی، که در آن انسان از حلقه تصمیمگیری نهایی حذف میشود، به رژیم صهیونیستی اجازه میدهد تا عملیاتهای تروریستی پیچیدهای را با کمترین ریسک برای عوامل خود و با قابلیت انکار بالا اجرا کند. این دیگر یک عملیات تروریستی سنتی نیست، بلکه یک اعدام الگوریتمی است که توسط ماشین انجام میشود. این روند در مورد ترور دیگر شهدای هستهای مانند شهیدان شهریاری، احمدی روشن و رضایینژاد نیز قابل تعمیم است، جایی که ردیابیهای طولانیمدت و حملات دقیق، نشان از بهکارگیری تحلیلهای پیشرفته اطلاعاتی دارد که امروزه توسط هوش مصنوعی تقویت میشوند.

بخش ۴: همدستی غولهای فناوری و خلاء پاسخگویی

این ماشین ترور بدون زیرساختهای فراهمشده توسط غولهای فناوری غربی نمیتواند عمل کند. گزارشها نشان میدهد که ارتش رژیم صهیونیستی برای سیستمهای هوش مصنوعی خود از خدمات شرکتهای آمریکایی مانند گوگل، آمازون و مایکروسافت بهره میبرد. پلتفرمهای ابری و مدلهای هوش مصنوعی این شرکتها برای چرخه هدفگیری حیاتی هستند. این امر یک «منطقه خاکستری» از مشروعیت تحت قوانین بینالمللی ایجاد میکند. زمانی که سرورهای یک شرکت تجاری میزبان مدلهای هوش مصنوعی هستند که لیستهای کشتار تولید میکنند، زیرساختهای آن شرکت میتواند به عنوان یک «هدف دو منظوره» تلقی شود که به اقدام نظامی کمک مؤثری میکند.

این همکاری، شرکتهای فناوری غربی را به همدستان جنایات جنگی و تروریسم دولتی رژیم صهیونیستی تبدیل میکند. آنها با ارائه ابزارهای لازم برای این کشتارها، مسئولیت اخلاقی و حقوقی مستقیمی دارند.

علاوه بر این، ماهیت پراکنده و غیرشفاف سیستمهای هوش مصنوعی یک «خلاء پاسخگویی» ایجاد میکند. هنگامی که یک حمله با کمک هوش مصنوعی به طور غیرقانونی غیرنظامیان را میکشد یا یک دانشمند را در کشوری دیگر ترور میکند، چه کسی مسئول است؟ برنامهنویسی که الگوریتم مغرضانه را نوشته است؟ تحلیلگر اطلاعاتی که دادههای ناقص را به سیستم داده است؟ فرماندهی که تصمیم ماشین را «مهر» کرده است؟ یا رهبران سیاسی که استقرار سیستمی با نرخ خطای مشخص را مجاز کردهاند؟ این ابهام، به رژیم صهیونیستی اجازه میدهد تا از زیر بار مسئولیت شانه خالی کند و مصونیت سیستماتیک برای جنایات خود ایجاد نماید. البته در جریان حملات انتقامی موشکی ایران تاسیسات هوش مصنوعی رژیم در منطقه بئرالسبع بارها هدف حملات سنگین موشکی واقع شدند و همین امر هشدار ایران به شرکت های طرف همکار با ماشین ترور رژیم صهیونیستی محسوب میشده است.

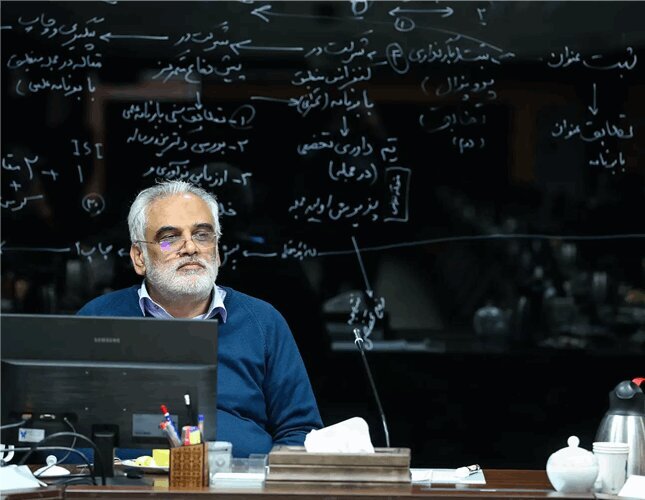

حمله موشکی ایران به ساختمانی درمنطقه بئر السبع در سرزمین های اشغالی

ادغام هوش مصنوعی در ترور فیزیکی افراد، نقطه عطفی در تاریخ جنگ و تروریسم است. این گزارش نشان داد که هوش مصنوعی ابزاری است که به طور عمیق نیت و دکترین کاربر خود را تقویت میکند. رژیم صهیونیستی از این فناوری نه برای دقت، بلکه برای سرعت و مقیاس در یک «کارخانه ترور جمعی» استفاده کرده است. این مدل که در غزه آزمایش شده، یک سابقه جهانی خطرناک ایجاد کرده و مستقیماً امنیت ملی ایران را از طریق ترور هدفمند نخبگانش تهدید میکند.

مقابله با این تهدید چندوجهی نیازمند اقدامی فوری و هماهنگ است:

1. تقویت توانمندیهای ملی: ایران باید سرمایهگذاری در توانمندیهای بومی هوش مصنوعی را برای کاربردهای دفاعی، ضدجاسوسی و امنیت سایبری تسریع کند. توسعه الگوریتمهای پیشرفته برای شناسایی الگوهای مشکوک و مقابله با سیستمهای نظارتی و تهاجمی دشمن، یک ضرورت استراتژیک است.

2. افشاگری بینالمللی: باید نقش و همدستی شرکتهای فناوری غربی در جنایات رژیم صهیونیستی در سطح بینالمللی افشا شود. ایران میتواند با ارائه مستندات، این شرکتها را تحت فشار افکار عمومی و نهادهای حقوقی قرار دهد.

3. پیگیری یک معاهده بینالمللی الزامآور: جامعه جهانی باید فراتر از اعلامیههای غیرالزامآور حرکت کرده و به طور جدی به دنبال یک معاهده بینالمللی الزامآور در مورد سیستمهای تسلیحاتی خودکار باشد. ایران باید در کنار دیگر کشورهای مستقل، برای ممنوعیت «رباتهای قاتل» و تنظیم دقیق هوش مصنوعی نظامی تلاش کند تا از گسترش تروریسم الگوریتمی جلوگیری شود.

آینده میدان نبرد، میدانی است که در آن سرعت جنگ الگوریتمی به طور مداوم از ظرفیت تصمیمگیری انسانی، تأمل اخلاقی و نظارت قانونی پیشی میگیرد. مقابله با این تهدید، نیازمند هوشیاری، نوآوری و اراده سیاسی برای دفاع از حاکمیت ملی و جان شهروندان در برابر جلادان الگوریتمی عصر جدید است.