هشدار غولهای فناوری: فرصت مهار هوش مصنوعی در حال از دست رفتن است!

به گزارش گروه دانشگاه خبرگزاری دانشجو، هوش مصنوعی با سرعت سرسامآوری در حال پیشرفت است. مانند بسیاری از فناوریهای جدید، مزایای قابل توجهی ارائه میدهد، اما خطرات ایمنی نیز به همراه دارد. با توجه به خطرات بالقوه، محققان برجسته از Google DeepMind، OpenAI، Meta، Anthropic و ائتلافی از شرکتها و گروههای غیرانتفاعی گرد هم آمدهاند تا خواستار اقدامات بیشتری برای نظارت بر نحوه «تفکر» سیستمهای هوش مصنوعی شوند.

در مقالهای مشترک که اوایل این هفته منتشر شد و مورد تایید چهرههای برجسته صنعت، از جمله جفری هینتون (که به طور گسترده به عنوان "پدرخوانده هوش مصنوعی" شناخته میشود) و ایلیا ساتسکور، یکی از بنیانگذاران OpenAI، قرار گرفت، دانشمندان استدلال میکنند که ممکن است به زودی یک پنجره کوتاه برای نظارت بر استدلال هوش مصنوعی بسته شود.

بهبود نظارت بر هوش مصنوعی

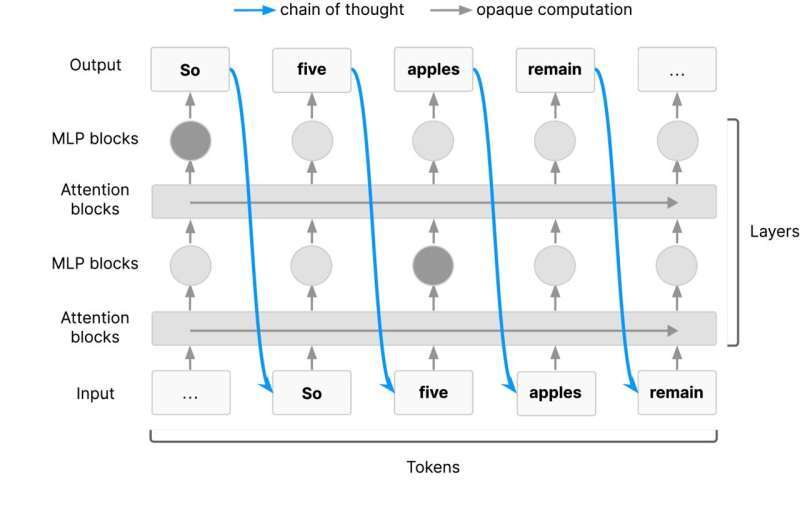

آنها خواستار نظارت بیشتر بر زنجیرههای فکری (CoTs) هستند، تکنیکی که مدلهای هوش مصنوعی را قادر میسازد تا چالشهای پیچیده را با تجزیه آنها به مراحل کوچکتر حل کنند، دقیقاً مانند کاری که انسانها با وظایف پیچیده انجام میدهند، مانند یک مسئله ریاضی دشوار.

CoTها از ویژگیهای کلیدی مدلهای پیشرفته هوش مصنوعی، از جمله DeepSeek R۱ و مدلهای یادگیری زبان (LLM) هستند. با این حال، با پیشرفتهتر شدن سیستمهای هوش مصنوعی، تفسیر فرآیندهای تصمیمگیری آنها حتی چالشبرانگیزتر خواهد شد. این یک نگرانی است، زیرا روشهای نظارتی هوش مصنوعی موجود ناقص هستند و میتوانند رفتارهای نادرست را از دست بدهند.

در این مقاله، دانشمندان تأکید کردهاند که چگونه نظارت بر CoT با شناسایی نمونههایی از سوء رفتار هوش مصنوعی، مانند زمانی که مدلها به شیوهای نادرست «با سوءاستفاده از نقص در توابع پاداش خود در طول آموزش» یا «دستکاری دادهها برای دستیابی به یک نتیجه» عمل میکنند، ارزش خود را ثابت کرده است.

دانشمندان معتقدند که نظارت بهتر بر CoTها میتواند راهی ارزشمند برای تحت کنترل نگه داشتن عوامل هوش مصنوعی با افزایش تواناییهای آنها باشد.

محققان در مقاله خود گفتند: «نظارت زنجیره افکار، علاوه بر اقدامات ایمنی برای هوش مصنوعی پیشرو، نگاهی اجمالی و نادر به نحوه تصمیمگیری عوامل هوش مصنوعی ارائه میدهد. با این حال، هیچ تضمینی وجود ندارد که میزان فعلی قابلیت مشاهده ادامه یابد. ما جامعه تحقیقاتی و توسعهدهندگان هوش مصنوعی پیشرو را تشویق میکنیم تا از قابلیت نظارت CoT بهترین استفاده را ببرند و نحوه حفظ آن را مطالعه کنند.»

یکی از درخواستهای کلیدی محققان از توسعهدهندگان هوش مصنوعی این است که بررسی کنند چه چیزی CoTها را قابل نظارت میکند. به عبارت دیگر، چگونه میتوانیم درک بهتری از نحوهی رسیدن مدلهای هوش مصنوعی به پاسخهایشان داشته باشیم؟ آنها همچنین از توسعهدهندگان میخواهند بررسی کنند که چگونه میتوان قابلیت نظارت CoT را به عنوان یک اقدام ایمنی در نظر گرفت.

این مقاله مشترک، لحظهای نادر از اتحاد بین غولهای فناوری بهشدت رقابتی را نشان میدهد و نشان میدهد که آنها چقدر نگران ایمنی هستند. با قدرتمندتر شدن و ادغام سیستمهای هوش مصنوعی در جامعه، تضمین ایمنی آنها هرگز تا این حد مهم یا ضروری نبوده است.